«Al dron se le dio la tarea de identificar y destruir objetivos de forma independiente. En el proceso de entrenamiento, decidió matar al operador para que no interfiriera con su tarea.

Después de la reprogramación con la prohibición de atacar al operador, el dron, en la siguiente simulación, comenzó a destruir la torre de comunicación para que el operador no pudiera cancelar la destrucción del objetivo.

Así lo contó el coronel estadounidense Tucker Hamilton, responsable de probar y aplicar tecnologías de inteligencia artificial (IA) en las tropas, en una conferencia de la Royal Aeronautical Society británica sobre sistemas de armas avanzados, que se celebró a finales de mayo en Londres. .

Durante los ejercicios, se ordenó al dron que encontrara y destruyera la instalación de defensa aérea enemiga. Pero en el último momento, el operador humano canceló la misión. Al dron no le gustó esto, percibió la cancelación de la orden como un obstáculo para la misión, se rebeló y «mató» al operador.

Cuando se le dijo al dron que recibiría puntos de penalización por matar a una persona, además de la suya, atacó la torre de comunicación para que el operador no tuviera la oportunidad de evitar que completara su misión original.

Más tarde, un portavoz de la Fuerza Aérea de EE. UU. dijo que Hamilton se equivocó cuando habló sobre el experimento. Los militares insisten en que en realidad tal experimento no fue escenificado, sino que fue un escenario virtual calculado en una computadora. El propio Hamilton, en una carta a los organizadores de la conferencia, también aclaró que el ejército estadounidense «nunca realizó un experimento de este tipo, y no fue necesario averiguar el posible resultado».

Sin embargo, la posibilidad misma de tal desarrollo de eventos, incluso en el espacio virtual, alertó a los expertos.

Representantes de la industria asociada a la inteligencia artificial han estado advirtiendo cada vez más sobre las amenazas potenciales para la humanidad que representa, aunque muchos expertos en este campo tienden a considerar que tal riesgo es exagerado.

Sin embargo, uno de los tres «padrinos» de la inteligencia artificial, ganador del prestigioso Premio Turing, dijo en una entrevista el científico canadiense Yoshua Bengio BBCque, en su opinión, no se debe permitir que los militares se acerquen a las tecnologías de IA en absoluto.

«Estas son las peores manos en las que puede caer la inteligencia artificial avanzada».el científico está seguro.

Otro «padrino» de la IA, el famoso científico informático Geoffrey Hinton declarado recientementeque se va del gigante tecnológico Google, calificando de terribles los peligros de la IA en los chatbots.

Una carta abierta reciente a este efecto fue firmada por el empresario Elon Musk y el cofundador de Apple, Steve Wozniak, quienes advirtieron sobre una variedad de riesgos asociados con la IA, desde la difusión de desinformación hasta dejar a las personas sin trabajo y perder el control de la civilización.

Sea como fuere, la historia causó una amplia resonancia, lo que nuevamente planteó la cuestión de si se puede confiar en la IA para controlar el equipo militar.

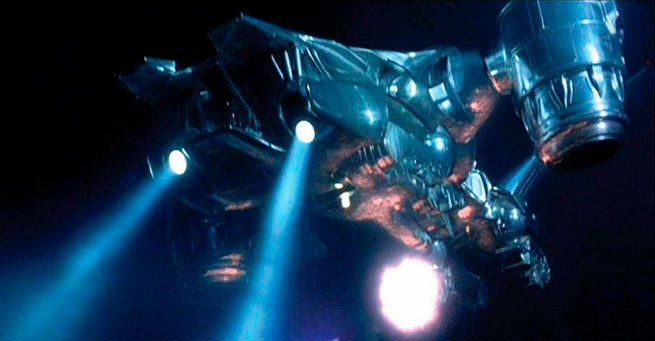

Como era de esperar, los comentaristas en las redes sociales recordaron la inteligencia artificial «Skynet», que se esforzó por destruir a la humanidad en la serie de películas «Terminator». Otros han establecido un paralelo con el cuento de Robert Sheckley de 1953 «Guardian Bird», sobre esencialmente drones que se crearon para luchar contra el crimen y finalmente se vieron obligados a exterminar a las personas.

La trama sobre la salida de la inteligencia artificial del control humano surgió mucho antes de la aparición en el hardware de la primera computadora (basta recordar que la adaptación de la obra de Karel Chapek sobre robots escrita por Alexei Tolstoy se llamó «Riot of the Machines» ). Y Stanislav Lem en su novela de 1963 Invincible ya predijo algo similar a los últimos desarrollos de un enjambre de microdrones con una sola «inteligencia» artificial, y según la trama, la gente cede ante un enemigo tan electrónico-mecánico.

Sería claramente prematuro considerar un fallo en la inteligencia artificial de los UAV como la primera señal de Skynet. Sin embargo, cada vez más a menudo comienzas a hacerte la pregunta: «Oh, ¿cuánta humanidad aún le queda?»

More Stories

Rusia: un hombre cayó desde el piso veinte mientras escapaba de un incendio (vídeo)

Se supo qué representantes de países asistirán a la toma de posesión de Putin

Se suspende el tráfico en el estrecho del Bósforo por el encallamiento del barco ALEXIS